时间倒回两年前,英伟达有意在深度学习的设备市场上对英特尔发起直接挑战,推出了 Pascal 架构的 P100 GPGPU。在当时,主流服务器PCIe 总线接口的带宽和时延,已经无法满足英伟达的需求。于是它们开发出了一个新的设备内互联标准,叫做 NVLink,使得带宽达到了 300 GB/s。一个 8 枚 GPGPU 的系统里,NVLink 大概长这样:

然而 NVLink 的标准拓扑结构在理论上最多支持 8 枚 显卡,仍不足以满足英伟达对于新系统内置更多显卡的需要。于是在 NVLink 的基础上,英伟达开发出了一个名专门在显卡之间管理 NVLink 任务的协处理器,命名为 NVSwitch。这个元件在 DGX-2 上,让 16 枚 GPGPU 中两两之间实现 NVLink 互通,总带宽超过了 14.4 TB。

这一数字创造了桌面级电脑内总线接口带宽的新高,但实现它的目的并非跑分,而在于 DGX-2 可以 1)更快速地训练一个高复杂度的神经网络,或 2)同时训练大量不同结构的神经网络。

英伟达 CEO 黄仁勋,背景是 NVSwitch 示意图

N 卡之所以被称为核弹有一种另类的解释方式:它的多核心架构在这个依核心数量论高下的时代显得超凡脱俗——动辄几百、上千个 CUDA 核心,令人不明觉厉。而在 DGX-2 上,16 枚 V100 的 CUDA 核数达到了疯狂的 81,920 核心。这一事实,结合 NVSwitch 技术、512GB 现存、30TB NVMe 固态硬盘、两枚至强 Platimum CPU 和高达 1.5TB 的主机内存——

黄仁勋用 GPU 深度学习里程碑式的杰作 AlexNet 来举例。研究者 Alex Krizhevsk 用了 6 天,在英伟达 GPU 上训练 AlexNet,这个研究首次利用梯度下降法和卷积神经网络进行计算机图像识别,显著优于此前的手调参数法,拿下了 ImageNet 图像识别竞赛冠军。AlexNet 让 Alex 世界闻名,这 6 天可以说值了。

然而,“同样的 8 层卷积神经网络,我用 DGX-2 跑了一下,只用 18 分钟就达到了同样的结果,”黄仁勋说,“五年,500倍的进步。”

这说明了很多东西。其中有一条:在这五年里,英伟达的技术进步节奏已经无法用摩尔定律来描述了。

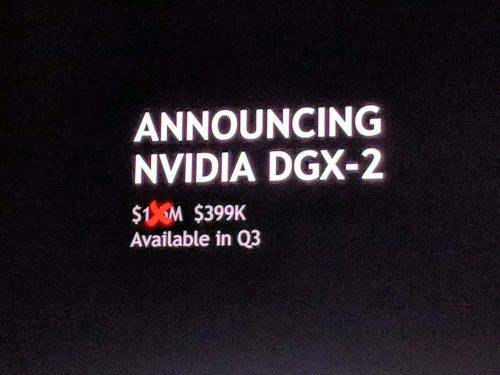

DGX-2 主要的应用场景是显著加速高端科研和商业人工智能产品的研发和面市。它显然不是一台消费级的产品——高达 150万美元的售价……

开玩笑的,最终售价是 40 万美元……